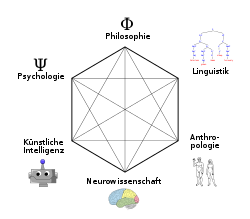

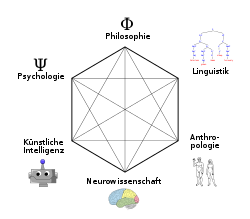

Kognitionswissenschaft

Kognitionswissenschaft ist eine interdisziplinäre Wissenschaft, die sich mit der Verarbeitung von Information im Rahmen von Wahrnehmungs-, Denk- und Entscheidungsprozessen befasst, sowohl beim Menschen als auch bei Tieren oder Maschinen. In ihren Bereich fallen auch Themen wie Gedächtnis, Lernen, Sprache, Emotion, Motivation und Volition.[1]

Die Kognitionswissenschaft abstrahiert dabei teilweise davon, ob Kognition in organischen Systemen und Lebewesen oder in künstlichen Systemen wie Computern oder Robotern untersucht wird, indem sie kognitive Prozesse als Informationsverarbeitung betrachtet. Methodisch arbeitet sie auf verschiedenen Ebenen:

- der Theoriebildung, die zur Hypothesenbildung dient,

- der kognitiven Modellierung, die kognitive Leistungen mit Hilfe von Computermodellen simuliert und neue Hypothesen in diese Modelle integriert,

- und der empirischen Ebene, die sich mit der empirischen Überprüfung der Modelle und der konkreten Implementierung kognitiver Leistungen befasst.

Wissenschaftliche Fächer, die an der Kognitionswissenschaft beteiligt sind, sind vor allem Psychologie, Neurowissenschaft, Informatik/künstliche Intelligenz, Linguistik und Philosophie, aber auch Anthropologie und Soziologie.

Entwicklung der Kognitionswissenschaft

Geschichte der Kognitionswissenschaft

Die Entwicklung der Kognitionswissenschaft wird von manchen mit der Vorstellung einer so genannten „kognitiven Wende“ (ca. 1940–1970) in Zusammenhang gebracht. Bis dahin hatte in der Psychologie und der Philosophie des Geistes der Behaviorismus eine maßgebliche Rolle gespielt. Der Behaviorismus war als eine Reaktion auf die Probleme der Introspektion als einer psychologischen Forschungsmethode entstanden. Introspektive Berichte über das mentale Innenleben waren für die Wissenschaftler nicht von außen überprüfbar. Der Behaviorismus zog daraus die Konsequenz, dass sich die Psychologie auf eine Erforschung des Verhaltens beschränken müsse. In der Philosophie des Geistes ging etwa Gilbert Ryle noch einen Schritt weiter und behauptete, dass mentale Zustände nicht mehr als Verhaltensdispositionen seien.

1956 fand am Massachusetts Institute of Technology das Symposium on Information Theory statt, an dem sich die KI-Pioniere Allen Newell, Herbert A. Simon und Marvin Minsky sowie der Linguist Noam Chomsky beteiligten. Chomsky präsentierte eine scharfe Kritik am Behaviorismus und stellte seine einflussreiche Transformationsgrammatik vor. Newell und Simon stellten den Logical Theorist vor, der erstmals selbständig ein Theorem der Mathematik „beweisen“ konnte. Wichtige Vorläufer dieser Entwicklung waren die Formulierung der Kybernetik durch Norbert Wiener und das Werk Alan Turings, der die Turingmaschine entwarf und den Turing-Test entwickelte.

Die Kognitionswissenschaft, die sich im Kontext der beschriebenen Entwicklungen konstituierte, basierte auf einer zentralen Annahme, die das „Computermodell des Geistes“ genannt wurde. Damit ist die These gemeint, dass das Gehirn ein informationsverarbeitendes System sei und prinzipiell wie ein Computer arbeite. Die Unterscheidung zwischen Geist und Gehirn lasse sich analog zu der Unterscheidung zwischen Software und Hardware verstehen. So wie die Software durch Datenstrukturen und Algorithmen bestimmt sei, sei der Geist durch mentale Repräsentationen und Rechenprozesse bestimmt. So wie die abstrakte Beschreibung der Software möglich sei, ohne direkt die Hardware zu untersuchen, sollte eine abstrakte Beschreibung der geistigen Fähigkeiten möglich sein, ohne direkt das Gehirn zu untersuchen. Und so, wie die Existenz einer Softwareebene problemlos mit dem Materialismus zu vereinbaren sei, sollte auch die mentale Ebene in eine materialistische Interpretation eingebettet sein.

Aktuelle Entwicklungen

Das Computermodell des Geistes ist in den letzten Jahrzehnten einer scharfen Kritik unterzogen worden. Diese Kritik hat im Wesentlichen zwei Quellen: Zum einen hat sich die Beschreibung des Gehirns durch die Kognitive Neurowissenschaft rasant entwickelt. Dies zeigt sich etwa in der zunehmenden Bedeutung von bildgebenden Verfahren, die es unplausibel machen, das Gehirn bei der Erforschung des Geistes nicht zu beachten. Zum anderen haben sich andere erfolgreiche Ansätze entwickelt, so der Konnektionismus und die Modellierung von neuronalen Netzen. Künstliche neuronale Netze werden unter anderem programmiert, um die Aktivitäten von Neuronenverbänden zu simulieren. Es ist zweifelhaft, inwieweit hier noch eine Unterscheidung von Software- und Hardwareebene möglich ist.

Andere alternative Paradigmen in der Kognitionswissenschaft sind z. B. der Dynamismus (Lehre, nach der sich alle Erscheinungsformen oder die Wirklichkeit durch die Wirkung von Kräften erklären lässt),[2] Künstliches Leben (Artificial Life) und die verkörperlichte und situierte Kognitionswissenschaft. Nach Ansicht des Dynamizismus stellt die Theorie der dynamischen Systeme ein geeignetes Modell des kognitiven Verhaltens bereit, da kognitives Verhalten immer in einem zeitlichen Zusammenhang stattfindet und zeitliche Koordination erfordert. Es wird postuliert, dass dieser zeitliche Aspekt der Kognition, der im Computermodell des Geistes vernachlässigt wird, essentiell ist. Andererseits stellt dieser Ansatz die Zentralität der internen Repräsentation und der Symbolmanipulation (vgl. Symbolismus) in Frage, da diese Konzepte nicht Teil einer dynamischen Erklärung sind.

„Künstliches Leben“ ist ein Terminus, der der Künstlichen Intelligenz gegenübersteht: anstatt abstrakte Aufgaben zu lösen (wie Schachstellungen analysieren), was uns Menschen oft schon wegen der bloßen Anzahl der Lösungsmöglichkeiten schwierig erscheint, Computern jedoch leicht fällt, solle man erst die Bewältigung der vermeintlich profanen Alltagsprobleme verstehen. Viele Aufgaben, die uns einfach erscheinen (wie Laufen, Freunde und Feinde erkennen, einen Ball fangen) sind von Computern oder Robotern derzeit noch gar nicht oder nur sehr eingeschränkt zu bewältigen.

Die verkörperlichte und situierte Kognitionswissenschaft wiederum geht davon aus, dass Kognition nicht ohne Bezug auf einen spezifischen Körper (Verkörperlichung, Embodiment) und eine spezifische Umgebung (Situiertheit) erklärt werden kann. Diese Forderungen resultieren aus dem Zweifel daran, dass Kognition ein Prozess ist, der sich in einer Welt der abstrakten symbolischen Repräsentationen vollzieht, verhältnismäßig unabhängig von der genauen Sensorik, Motorik und dem zeitlichen Geschehen in der Außenwelt. Bekannte Vertreter dieser Auffassung sind Alva Noë, Susan Hurley, Evan Thompson, Francisco Varela und Kevin O’Regan. Im Rahmen der verkörperlichten und situierten Kognitionswissenschaft wird häufig eine Verknüpfung vom Gedankengut der Phänomenologie Maurice Merleau-Pontys und Edmund Husserls mit der klassischen analytischen Philosophie des Geistes angestrebt.

Diese verschiedenen Strömungen (Konnektionismus, Dynamizismus, Künstliches Leben, Situiertheit und Verkörperlichung) werden gerne unter dem Schlagwort Neue KI (New AI) zusammengefasst, da sie sich z. T. in ihren Forderungen und Annahmen überlappen. Allerdings können sie nicht als deckungsgleich betrachtet werden, da sie sich in vielerlei Weise in Prämissen, Konsequenzen und Anwendungen unterscheiden oder sogar widersprechen.

Die Kritik am Computermodell des Geistes führte zeitweise zur generellen Infragestellung der Kognitionswissenschaft. Mittlerweile haben sich die Wogen jedoch weitgehend geglättet. Kognitionswissenschaftler verwenden nun selbst auch neuronale Netze und stehen in einem engen Kontakt mit der Kognitiven Neurowissenschaft.

Philosophie der Kognition

In der Kognitionswissenschaft werden Themen untersucht, die beim Menschen Bewusstsein bzw. Selbstbewusstsein voraussetzen. Dazu werden einzelne Aspekte des Bewusstseins wie Wahrnehmung, Gedanken oder Erinnerungen betrachtet und allgemein als mentale Zustände bezeichnet. „Höhere“ kognitive Fähigkeiten wie Lernen, Problemlösen und Sprechen setzten wiederum Denken – also mentale Zustände – voraus. Es ist daher für die Kognitionswissenschaft von hoher methodologischer Bedeutung, zu klären, was mit der Rede von mentalen Zuständen gemeint ist. Mit dem Computermodell des Geistes ist eine klassische Position der Philosophie des Geistes verbunden – der Funktionalismus.

Der Funktionalismus, der in den 1960er Jahren von Hilary Putnam entwickelt wurde, behauptet, dass mentale Zustände funktionale Zustände sind. Ein funktionaler Zustand ist dabei durch seine kausale Rolle in einem System spezifiziert. Man kann den Begriff des funktionalen Zustandes recht gut am Beispiel von einfachen Automaten erklären: Stellen wir uns einen Süßigkeitenautomaten vor. Dieser wirft nach Erhalt eines Euros eine Süßigkeit aus. Nun kann man den Automaten mit verschiedenen Zuständen beschreiben: Es muss einen Zustand geben, in dem der Automat die Süßigkeit auswirft ohne weiteres Geld zu fordern. Es muss aber auch Zustände geben, in denen der Automat noch 1 Euro oder 50 Cent fordert, um etwas auszuwerfen. Jeder dieser Zustände des Automaten ist ein funktionaler Zustand. Er ist dadurch spezifiziert, dass er bei einem bestimmten Input (hier: 50 Cent oder 1 Euro) auf bestimmte Weise reagiert: Er hat einen bestimmten Output (hier: Süßigkeit oder nicht) und geht in einen anderen Zustand über.

Das Entscheidende bei dieser Überlegung ist, dass die Beschreibung des funktionalen Zustandes davon unabhängig ist, woraus und wie der Süßigkeitenautomat konkret gebaut ist. Wenn mentale Zustände auch funktionale Zustände wären, so wäre auch irrelevant, ob der funktionale Zustand in einem Gehirn oder in einem Computer realisiert ist. Damit wären auch die Bedingungen klar, die gegeben sein müssen, damit ein Computer mentale Zustände haben kann: Der Computer müsste nur die gleichen funktionalen Zustände realisieren. Dies scheint auch möglich zu sein. Schon die 1936 von Alan Turing als mathematisches Modell formulierte Turingmaschine kann im Prinzip beliebige funktionale Zustände realisieren.

Kognitive Fähigkeiten und kognitive Architekturen

Menschen verfügen über zahlreiche verschiedene kognitive Fähigkeiten: Gedächtnis, Sprache, Wahrnehmung, Problemlösen, geistiger Wille, Aufmerksamkeit und weitere. Ziel der Kognitionspsychologie ist es, die Eigenarten dieser Fähigkeiten zu erforschen und, so weit wie möglich, in formalen Modellen zu beschreiben. Diese Modelle können dann als kognitive Architektur auf einem Computer realisiert werden. Auch die künstliche Intelligenz (KI) hat das Ziel, kognitive Fähigkeiten in Maschinen zu realisieren. Dabei dürfen die künstlichen Agenten jedoch – im Gegensatz zu kognitiven Architekturen – auch Strategien verwenden, die von Menschen nicht genutzt werden.

Problemlösen

„Problemlösen“ nennt man Handlungen, die darauf ausgerichtet sind, einen Zielzustand zu erreichen. Problemlöseprozesse sind daher etwas Alltägliches, sie sind etwa für die Tagesplanung, das Rechnen, das Schachspielen oder die Routenplanung einer Reise notwendig. Schon früh war es das Ziel der künstlichen Intelligenz, Maschinen die Fähigkeit zum Problemlösen zu geben.

Dabei wird in der künstlichen Intelligenz ein Start- und ein Zielzustand spezifiziert. Die Aufgabe ist, den (oder einen) Weg zum Ziel zu finden. Hierbei gibt es prinzipiell zwei Ansätze: Zum einen kann das Programm versuchen, blind den Weg zum Ziel zu finden, indem es alle verschiedenen Wege ausprobiert (Brute-Force-Methode), wie es bei der Tiefensuche oder der Breitensuche geschieht. Dieser Ansatz kommt jedoch schnell an seine Grenzen, da die Anzahl der möglichen Wege in NP-vollständigen Problemen so hoch ist, dass ein Ausprobieren die Rechenkapazität der Maschine übersteigen würde. In einem solchen Fall sind Suchalgorithmen, welche Heuristiken verwenden, notwendig, wie der A*-Algorithmus. Heuristiken beschreiben Auswahlmechanismen, welche die erfolgversprechendsten Verfahren bereits vor der Ausführung zu bestimmen versuchen.

Das erste Programm, das intensiv mit Heuristiken arbeitete, war der General Problem Solver (GPS) von Allen Newell und Herbert A. Simon. Der GPS war zum Auffinden von Lösungswegen wie etwa beim Türme-von-Hanoi-Spiel fähig. Das Spiel besteht aus einer Reihe verschieden großer Scheiben und drei Spielfeldern. Beim Spielbeginn liegen alle Scheiben auf dem linken Feld. Das Ziel ist erreicht, wenn sich alle Scheiben auf dem rechten Feld befinden. Dabei darf jede Scheibe jedoch nur auf einer größeren Scheibe liegen und jeweils nur eine Scheibe entweder auf den linken, den mittleren oder den rechten Platz bewegt werden. Obwohl das Problem mit einem Algorithmus lösbar ist, lösen Menschen dieses Problem häufig mit Heuristiken, da die Anzahl möglicher Wege rasant wächst.

Die Lösung von Spielen wie den Türmen von Hanoi war in der Frühzeit der künstlichen Intelligenz eine beliebte Aufgabe. Das liegt darin begründet, dass hier nur eine recht begrenzte Anzahl von Aktionen möglich ist und es keine unvorhersagbaren Ereignisse gibt. Die experimentelle Überprüfbarkeit von kognitiven Strategien wurde dadurch erleichtert. Dagegen widmet man sich nun auch komplizierten Alltagsaufgaben, wie etwa der erfolgreichen „Ausführung“ eines Restaurantbesuchs.

Kognitive Architekturen

Das Ziel einer kognitiven Architektur ist es, die verschiedenen Ergebnisse der kognitiven Psychologie in einem umfassenden Computermodell zusammenzufassen. Dabei müssen die Ergebnisse jedoch in einer so weit formalisierten Form vorliegen, dass sie Grundlage eines Computerprogramms sein können. Mit dem Zusammenfassen der einzelnen Ergebnisse sollen so zum einen eine umfassende Theorie der Kognition und zum anderen ein auch kommerziell nutzbares Modell entstehen. Die drei derzeit erfolgreichsten kognitiven Architekturen sind ACT-R (Adaptive Control of Thought, ACT), SOAR und EPIC. Mit dem PSI-Modell ist in den letzten Jahren ein weiterer Ansatz vorgestellt worden, der verglichen mit den anderen Architekturen weitgehend auf dem aktuellen Stand der Allgemeinen Psychologie basiert.

ACT-R ist ein Produktionssystem mit einer Reihe von Modulen. Es besteht aus Input- und Outputmodulen, einem Produktionengedächtnis und einem deklarativen Gedächtnis. Das Zielmodul legt fest, welches Ziel im Produktionssystem verfolgt werden soll. Im Produktionengedächtnis sind Regeln gegeben, die bestimmen, welche Aktion ausgeführt wird, wenn ein ausgewähltes Ziel erreicht werden soll, und welche Inhalte im Arbeitsgedächtnis (bzw. in unterschiedlichen Partitionen des Arbeitsgedächtnisses) vorliegen müssen, damit die Aktion erfolgreich durchgeführt werden kann. Dieses „Patternmatching“ führt ggf. zur Auswahl einer Produktionsregel und bestimmt die Aktion des Outputmoduls.

Kognitive Architekturen zeichnen sich durch die Erfüllung bestimmter Kriterien, den Core Cognitive Criteria (CCC), aus. Diese sind:[3]

- geeignete repräsentationale Datenstruktur(en)

- Unterstützung von Klassifikation

- Unterstützung des Frege-Prinzips

- Lösen des Bindungsproblems

- Produktivität

- Performance

- syntaktische Verallgemeinerung

- Robustheit

- Anpassungsfähigkeit

- Speicherverbrauch

- Skalierbarkeit

- selbstständiger Erkenntnisgewinn (logisches Schließen, Erkennung von Korrelation)

- Triangulation (Zusammenführen von Daten aus verschiedenen Quellen)

- Kompaktheit (möglichst einfache Grundstruktur)

Ein Computersystem, das diese Eigenschaften erfüllt, ist IBMs DeepQA.

Sprache und Kognition

Die Sprachbeherrschung gehört zu den herausragenden kognitiven Fähigkeiten des Menschen. Das Verfügen über Sprache ist zudem Voraussetzung für das Verfügen über einige andere kognitive Fähigkeiten. Ohne Sprache könnten zumindest viele Gedanken nicht gedacht und viele Probleme nicht gelöst werden. In der Kognitionswissenschaft hat die Sprache daher immer eine zentrale Rolle gespielt. Zum einen stellt sich die Frage, wie die menschliche Sprachbeherrschung möglich ist, zum anderen, wie man Maschinen zur Sprachbeherrschung bringen kann.

Sprachfähigkeit des Menschen

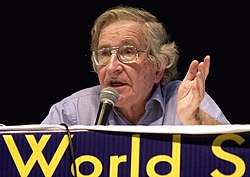

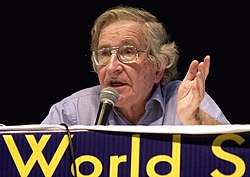

Wie kommt es, dass Menschen in aller Regel dazu fähig sind, Sprachen zu lernen? Bis ins zwanzigste Jahrhundert herrschte die Meinung, dass der Spracherwerb durch das Herausfiltern der Sprachregeln im Dialog mit anderen Menschen zu erklären sei. Eine solche, „Kognitivismus“ genannte, Position wurde etwa von Jean Piaget vertreten. Ihr zufolge ist die Sprachfähigkeit von der allgemeinen Denkfähigkeit abgeleitet. Dieser Theorie trat erstmals Noam Chomsky mit seiner „nativistisch“ genannten Position entgegen. Chomsky behauptet, dass Menschen genetisch mit einem Sprachorgan ausgestattet sind, das den Spracherwerb erst möglich macht. Das Sprachorgan wird dabei im Gehirn angesiedelt, allerdings nicht als eine fest umschriebene neuronale Region.

Chomsky argumentiert, dass der Spracherwerb durch einen kognitivistischen Ansatz nicht zu erklären sei. Der sprachliche Input der Mitmenschen reiche nicht aus, um die Regeln des korrekten Sprechens festzulegen. Zum einen sei die gesprochene Sprache nämlich sehr oft ungrammatisch, der Input somit defizitär. Zum anderen lasse der Input grammatische Fehler bei lernenden Kindern zu, die sie de facto jedoch nicht machen. Chomsky schließt daraus, dass es angeborenes Sprachwissen geben muss, auf das beim Spracherwerb zurückgegriffen werden kann. Dieses angeborene Wissen sei insbesondere grammatisches Wissen, allen Menschen sei eine Universalgrammatik bereits von Geburt an gegeben. Siehe auch: Angeborene bzw. Eingeborene Ideen.

Chomskys Hypothesen wurden in der als Linguistics Wars bezeichneten wissenschaftlichen Debatte der 1960er und 1970er Jahre heftig kritisiert: seine syntaxorientierte interpretative Semantik von George Lakoff und seine Universalgrammatik von der sogenannten linguistischen Relativitätstheorie Benjamin Whorfs.

Seit den 1980er Jahren wendet sich die Forschung zunehmend wieder Konzepten zu, welche – ähnlich Piaget – die Sozialisation beim Spracherwerb in den Mittelpunkt stellen. Chomskys Denkansatz wird – wie die gesamte traditionelle „Kopf-Philosophie“ – in konstruktivistischen Konzepten[4] und durch neurobiologische Modelle infrage gestellt:

Nach Humberto Maturana und Francisco Varela[5] – siehe auch: Der Baum der Erkenntnis (El árbol del conocimiento 1984) – ist das Gehirn nicht wie ein Input/Output-Modell aufgebaut, sondern hat – durch ein Netz von einhundertmilliarden Inter-Neuronen, die Millionen von motorischen und sensorischen Nervenzellen miteinander verbinden – die Fähigkeit zur intensiven Parallelverarbeitung. Eine repräsentative Vorstellung mit einer Abbildung eines Begriffs im Gehirn ist für Maturana und Varela kaum haltbar, da an den Schaltstellen Hunderte von Neuronen aus anderen Teilen des Nervensystems mit vielfältigen Effekten konvergieren und zu Überlagerungen führen. Das Nervensystem arbeite nicht mit Repräsentationen einer unabhängigen Außen-Welt. Wörter als Bezeichnungen von Objekten oder Situationen in der Welt würden nicht der Tatsache der Strukturkoppelung gerecht, vielmehr seien sie ontologisch festgelegte Koordinationen von Verhalten. Sprache entsteht nach Maturana und Varela nicht in einem einheitlichen Entwurf (ist kein Bestandteil des Gehirns), sondern ist das durch Koordination von Handlungen erlernte variable kommunikative Verhalten (Sprache ist Teil des Milieus, das als „Reich der Sprache“ bezeichnet wird:[6] Unser gemeinsames „In-der-Sprache-Sein[-] ist das, was wir als Bewusstsein oder als ‚unseren Geist‘ und ‚unser Ich‘ erfahren“.[7]).

Dialog- und Expertensysteme

Der Versuch, Maschinen mit Sprachfähigkeit auszustatten, schlägt sich oft in Dialogsystemen nieder. Ein Dialogsystem ist meist ein Computerprogramm, mit dem man sich per Tastatur unterhalten kann. Eins der ersten erfolgreichen Dialogsysteme war ELIZA von Joseph Weizenbaum aus dem Jahre 1966. ELIZA simuliert einen Psychotherapeuten. Durch den geschickten Einsatz von Phrasen, wie „Erzählen sie mir mehr von X“ oder „Denken sie oft an X“ konnte ELIZA Testpersonen lange über ihre nichtmenschliche Existenz täuschen. Einige Testpersonen fühlten sich sogar so gut verstanden, dass sie sich jenseits der Testsituation privat mit ELIZA über ihre Probleme unterhalten wollten. Stellt man ELIZA jedoch Fragen, die nicht in den Kontext der Therapiesituation passen, so ist ELIZA zu keinen vernünftigen Antworten in der Lage.

Verwandt mit Dialogsystemen sind Expertensysteme, die mittlerweile auch zahlreiche kommerzielle Anwendungen haben. Expertensysteme versuchen das Wissen von menschlichen Experten zu speichern und dem Nutzer zur Verfügung zu stellen. Anwendungen sind etwa automatische Medizin- oder Technikexperten. Diese Experten setzen eine funktionierende Wissensrepräsentation voraus, durch die das Programm über das Wissen verfügt. In einer umfassenden Wissensrepräsentation muss das Material in günstiger Weise strukturiert sein, so dass immer auf das nötige Wissen zurückgegriffen werden kann, dass die Relationen zwischen den Wissenselementen klar sind und dass die Inhalte von dem Entwickler überblickt und gegebenenfalls erweitert werden können.

Der Turing-Test

Die Faszination von Dialogsystemen hängt eng mit einem Gedankenexperiment zusammen, das von dem Computerpionier Alan Turing 1950 formuliert wurde. Turing suchte ein klares Kriterium zur Entscheidung der Frage, wann Computer als intelligent gelten können. Seine Antwort war der berühmte Turing-Test: Ein Mensch tritt in den Dialog mit einem Computer – per Bildschirm und Tastatur. Der Computer kann genau dann als intelligent angesehen werden, wenn es dem Menschen schwerfällt zu entscheiden, ob es sich um einen Dialog mit einem Menschen oder mit einem Computerprogramm handelt.

Die heutigen Dialogsysteme sind noch sehr weit davon entfernt, den Turing-Test zu bestehen. Dies ist nicht verwunderlich, wenn man bedenkt, was ein Programm alles können müsste, um diesen zu bestehen. Es müsste etwa Witze erklären können, Anspielungen und Ironie verstehen und dem Kontext angepasste Fragen und Antworten formulieren. Es existiert mittlerweile der auf 100.000 Dollar dotierte Loebner-Preis für den Entwickler des ersten Programms, das den Turing-Test besteht.

Am Turing-Test ist viel Kritik geübt worden. Am bekanntesten ist wohl John Searles Chinesisches-Zimmer-Argument, das zeigen soll, dass das Bestehen des Turing-Tests nicht hinreichend für Verstehen von Sprache ist. Man stelle sich vor, man befände sich in einer riesigen Bibliothek. Von außen werden einem Blätter mit chinesischen Schriftzeichen hereingereicht, die man nicht versteht. Da in den Büchern der Bibliothek nur Folgen von chinesischen Schriftzeichen verzeichnet sind, kann man nun die Zeichenfolgen auf den Blättern heraussuchen. Jeder Zeichenfolge ist im Buch eine andere Zeichenfolge zugeordnet, die man schließlich auf das Blatt schreibt und wieder nach außen gibt. Durch diese Prozedur erscheint es einem außen stehenden Chinesen so, als würde er sich mit einem anderen chinesisch verstehenden Menschen unterhalten. Dabei versteht man selbst kein Chinesisch und die Bibliothek versteht auch kein Chinesisch. Also könnte ein System den Turing-Test bestehen, ohne dass es auch nur einen Funken von dem Gesagten versteht.

Der Konnektionismus

In der Kognitionswissenschaft hat die Entwicklung des Konnektionismus zu starken Veränderungen geführt. Während in der klassischen künstlichen Intelligenz – dem Computermodell des Geistes entsprechend – kognitive Fähigkeiten mit einer symbolischen Programmiersprache simuliert wurden, wird im Konnektionismus mit künstlichen neuronalen Netzen gearbeitet. Ein künstliches neuronales Netz ist eine Verschaltung einfacher Einheiten, der so genannten künstlichen Neuronen. Dabei können die Neuronen ihre Aktivitäten an die benachbarten Neuronen weitergeben. Dadurch können bei einem gegebenen Input komplizierte Erregungsmuster entstehen, die selbst wiederum einen Output erzeugen.

Das Konzept der neuronalen Netze wurde schon 1943 von Warren McCulloch und Walter Pitts entwickelt. 1949 entwickelte der Psychologe Donald O. Hebb die Hebbsche Lernregel, die sich in das Konzept der neuronalen Netze einbinden lässt. Nach Hebb lässt sich das Lernen dadurch beschreiben, dass man die einzelnen Verbindungen zwischen den Neuronen gewichtet. Ein Lernen findet statt, indem die Gewichtungen zwischen den Neuronen verändert werden. Trotz dieser frühen Entwicklung hin zu einem Modell lernender neuronaler Netze, blieb die Kognitionswissenschaft lange Zeit auf den symbolverarbeitenden Ansatz beschränkt (GOFAI).

Erst seit den 1980er Jahren wird in der Kognitionswissenschaft wieder vermehrt auf neuronale Netze zurückgegriffen. Dies liegt insbesondere daran, dass neuronale Netze dazu in der Lage sind, Aufgaben zu erledigen, bei dem der symbolverarbeitende Ansatz recht erfolglos geblieben ist. Zu solchen Aufgaben gehören etwa die Mustererkennung oder die Bewegung. Diese Entwicklung ist auch von theoretischer Bedeutung: Der Konnektionismus erkennt nämlich die – für die klassische Kognitionswissenschaft so wichtige – Unterscheidung zwischen Software und Hardware nicht mehr an.

Das Bindungsproblem in der Kognitionswissenschaft

Eines der Hauptziele in der Kognitionswissenschaft besteht darin, eine integrierte Theorie der Kognition zu entwickeln. Dies erfordert integrative Mechanismen, die erklären, wie die Informationsverarbeitung, die gleichzeitig in räumlich getrennten (sub-)kortikalen Arealen des Gehirns stattfindet, koordiniert und miteinander verbunden wird, um zu kohärenten Wahrnehmungs- und symbolischen Repräsentationen zu führen. Ein Ansatz besteht darin, dieses "Bindungsproblem"[8][9][10] (d. h. das Problem der dynamischen Repräsentation der Verbindungen von Informationselementen, von den einfachsten Wahrnehmungsrepräsentationen ("Merkmalsbindung") bis hin zu den komplexesten kognitiven Repräsentationen, wie Symbolstrukturen ("Variablenbindung")), mit Hilfe von integrativen Synchronisationsmechanismen zu lösen. Mit anderen Worten, einer der koordinierenden Mechanismen scheint die zeitliche (Phasen-)Synchronisation der neuronalen Aktivität zu sein, die auf dynamischen selbstorganisierenden Prozessen in neuronalen Netzwerken beruht und durch die Binding-By-Synchrony (BBS)-Hypothese aus der Neurophysiologie beschrieben wird.[11][12][13][14] Es sind nun konnektionistische kognitive Neuroarchitekturen entwickelt worden, die integrative Synchronisationsmechanismen verwenden, um dieses Bindungsproblem in der Wahrnehmungskognition und in der Sprachkognition zu lösen.[15][16][17] In der Wahrnehmungskognition ist dies das Problem, wie elementare Objekteigenschaften und Objektrelationen, wie die Objektfarbe oder die Objektform, dynamisch miteinander verbunden oder mittels eines Synchronisationsmechanismus zu einer Repräsentation dieses Wahrnehmungsobjekts integriert werden können ("Merkmalsbindung"). In der Sprachkognition ist dies das Problem, wie semantische Konzepte und syntaktische Rollen dynamisch miteinander verbunden bzw. mittels eines Synchronisationsmechanismus in komplexe kognitive Repräsentationen wie systematische und kompositionelle Symbolstrukturen und Propositionen integriert werden können ("Variablenbindung") (siehe auch die "Symbolismus vs. Konnektionismus-Debatte" im Konnektionismus).

Kognitionswissenschaft an den Universitäten

In den USA, aber auch in Großbritannien, Australien und den Niederlanden, ist Kognitionswissenschaft ein weit verbreitetes und anerkanntes Studienfach. Einflussreiche Institute befinden sich etwa an der Rutgers University, der Tufts University, der University of California, San Diego und an der University of California, Berkeley.

In Deutschland ist Kognitionswissenschaft als Studiengang jedoch noch nicht weit verbreitet. Es gibt an der Universität Osnabrück ein eigenes kognitionswissenschaftliches Institut mit einem Bachelor-, Master- und Promotionsprogramm, an der Universität Tübingen gibt es seit dem Wintersemester 2009/2010 den Bachelor- und Master-Studiengang Kognitionswissenschaft, angeboten von der Mathematisch-Naturwissenschaftlichen Fakultät. Seit dem Wintersemester 2019/2020 bietet die Technische Universität Darmstadt den Studiengang „Cognitive Science“ an.[18] An der Universität Potsdam gibt es Kognitionswissenschaften als Ein-Fach-Bachelor- und als forschungsorientierten Masterstudiengang.[19] Als Nebenfach kann man Kognitionswissenschaft an der Albert-Ludwigs-Universität Freiburg studieren. Seit dem Wintersemester 2012/2013 wird in Freiburg auch ein M.Sc. Studiengang angeboten. Seit dem WS 2013/2014 wird an der TU Kaiserslautern der englischsprachige Studiengang Cognitive Science (M.Sc.) angeboten. Verwandte Fächer sind der Bachelor-Studiengang Kognitive Informatik an der Universität Bielefeld, der Bachelor-Studiengang „Philosophie – Neurowissenschaften – Kognition“ an der Otto-von-Guericke-Universität Magdeburg und MEi:CogSci, das joint degree „Middle European interdisciplinary master programme in Cognitive Science“, das die Universitäten in Wien, Bratislava, Budapest und Ljubljana gemeinsam anbieten. An der Universität Duisburg-Essen gibt es den Bachelor- und Masterstudiengang „Angewandte Kognitions- und Medienwissenschaft“. An der Technischen Universität Chemnitz gibt es seit dem Wintersemester 2009/2010 den Bachelor- und Master-Studiengang Sensorik und kognitive Psychologie, der Schwerpunkte in technischer Sensorik, menschlicher Wahrnehmung sowie natürlicher und künstlicher kognitive Systeme setzt.[20]

Siehe auch

Literatur

Einführungen:

- John R. Anderson: Kognitive Psychologie. Eine Einführung. Spektrum der Wissenschaft, Heidelberg 1988, ISBN 3-922508-19-7. Eine fundierte Einführung, jedoch mit wenig Bezug zu den Neurowissenschaften.

- Howard Gardner: Dem Denken auf der Spur. Der Weg der Kognitionswissenschaft. Klett-Cotta, Stuttgart 1989 u. ö., ISBN 3-608-93099-X, ISBN 3-608-95866-5. Klassische Darstellung der Geschichte der Kognitionswissenschaft.

- Manuela Lenzen: Natürliche und künstliche Intelligenz. Einführung in die Kognitionswissenschaft. Campus, Frankfurt am Main u. a. 2002, ISBN 3-593-37033-6. Kurze, laienfreundliche Einführung.

- Rolf Pfeiffer, Christian Scheier: Understanding Intelligence. MIT Press, Cambridge (Mass.) 1999, ISBN 0-262-16181-8. Darstellung der modernen Ansätze in der Kognitionsforschung.

- Paul Thagard: Kognitionswissenschaft. Ein Lehrbuch. Klett-Cotta, Stuttgart 1999, ISBN 3-608-91919-8. Ebenfalls laienfreundliche Einführung, konzentriert auf philosophische und methodologische Aspekte.

- Max Urchs: Maschine – Körper – Geist. Eine Einführung in die Kognitionswissenschaft. Vittorio Klostermann, Frankfurt am Main 2002, ISBN 3-465-03196-2. Umfassende, aber verständliche Einführung von einem Mathematiker und Philosophen.

- Francisco J. Varela: Kognitionswissenschaft, Kognitionstechnik. Eine Skizze aktueller Perspektiven. Suhrkamp, Frankfurt am Main 1990, ISBN 3-518-28482-7. Beschreibt laienfreundlich die biologisch orientierte, nicht so sehr aber die klassische auf der Computermetapher basierende Kognitionswissenschaft.

Textsammlungen:

- Dieter Münch (Hrsg.): Kognitionswissenschaft. Grundlagen, Probleme, Perspektiven. 2. Auflage. Suhrkamp, Frankfurt am Main 2000, ISBN 3-518-28589-0. Enthält unter anderem deutsche Übersetzungen der „klassischen“ Aufsätze von Newell/Simon, Minsky, Fodor, Block, Searle und Dennett.

Lexika:

- Robert A. Wilson, Frank C. Keil (Hrsg.): The MIT Encyclopedia of the Cognitive Sciences. MIT Press, Cambridge (Mass.) u. a. 2001, ISBN 0-262-73144-4. Englischsprachiges Standardwerk.

- Gerhard Strube et al. (Hrsg.) Wörterbuch der Kognitionswissenschaft. Klett-Cotta, Stuttgart 1996, ISBN 3-608-91705-5. Als CD-Rom: Klett-Cotta, Stuttgart 2001, ISBN 3-608-94167-3.

Einzelthemen:

- Ansgar Beckermann: Analytische Einführung in die Philosophie des Geistes. 2. Auflage. De Gruyter, Berlin u. a. 2001, ISBN 3-11-017065-5. Sehr dichte Einführung in die Philosophie des Geistes.

- Rainer Dietrich: Psycholinguistik. Metzler, Stuttgart 2002, ISBN 3-476-10342-0. Laienfreundliche Einführung in die kognitionswissenschaftlichen Aspekte der Linguistik, allerdings ohne Neurolinguistik.

- E. Bruce Goldstein: Cognitive Psychology. Connecting Mind, Research and Everyday Experience. Thomson Wadsworth, Belmont (Calif.) u. a. 2004 u.ö., ISBN 0-534-57726-1. Eins der neuesten und am weitesten verbreiteten Lehrbücher der Kognitionspsychologie.

- Klaus Mainzer: KI – Künstliche Intelligenz. Grundlagen intelligenter Systeme. Primus, Darmstadt 2003, ISBN 3-89678-454-4. Einführung in die KI von einem Wissenschaftstheoretiker geschrieben. Daher auch für Nichtinformatiker verständlich.

- Horst M. Müller: Psycholinguistik – Neurolinguistik. Die Verarbeitung von Sprache im Gehirn. UTB, Paderborn 2013, ISBN 978-3-8252-3647-2.

Weblinks

- Thematische Einführungen

- Paul Thagard: Cognitive Science. In: Edward N. Zalta (Hrsg.): Stanford Encyclopedia of Philosophy.

- Daniel Kelly, Andreas De Block: Culture and Cognitive Science. In: Edward N. Zalta (Hrsg.): Stanford Encyclopedia of Philosophy.

- Gesellschaften

- Gesellschaft für Kognitionswissenschaft

- Cognitive Science Society

- The Society for the Study of Artificial Intelligence and Simulation of Behaviour, UK

- European Society for Cognitive Psychology in Englisch

- Institute und Forschergruppen

- Abteilung Informatik und Angewandte Kognitionswissenschaft der Universität Duisburg-Essen

- Department für Wissens- und Kommunikationsmanagement der Donau-Universität Krems

- Department of Cognitive Biology an der Universität Wien in Englisch

- Graduate School of Neural & Behavioural Sciences – International Max Planck Research School, Tuebingen

- Institut für Kognitionswissenschaft Freiburg

- Institut für Kognitionswissenschaft Osnabrück

- Middle European interdisciplinary master programme in Cognitive Science

- Rutgers University Center for Cognitive Science

- Zentrum für Kognitionswissenschaften (ZKW), interdisziplinäres Forschungsinstitut an der Universität Bremen: www.neuro.uni-bremen.de/~zkw

- Institut für Neuroinformatik (INI), interdisziplinäres Forschungsinstitut mit Fokus auf dem Schnittpunkt zwischen Kognitionswissenschaft und Informationstechnologie

- Datenbanken und Linksammlungen zu Aufsätzen und Forschern

- Cognitive Science Journal Archive: Wissenschaftliche Artikel und Konferenzbeiträge [Englisch]

- Mindpapers Bibliographie von David Chalmers zu Themen der Philosophie des Geistes, der Kognitionswissenschaften und der Bewusstseinstheorie mit mehr als 18.000 Titeln

- Sammlung von wichtigeren online verfügbaren Aufsätzen und Werken mit direktem Bezug zur Kognitionswissenschaft von Abstracta – Linguagem, Mente e Ação (ISSN 1807-9792) [Englisch]

- Dictionary of Cognitive Science: Wörterbuch der University of Alberta

- Liste von internationalen Instituten, die Cognitive Science Abschlüsse anbieten

- Liste der Indiana University

- Liste der University of Hong Kong (beinhaltet auch Abschlüsse in Unterdisziplinen, einige Links funktionieren nicht aber man findet die Programme meistens, wenn man auf die Homepage der Institute geht)

Einzelnachweise

- ↑ Vgl. Margaret Boden: Mind as Machine. A History of Cognitive Science, Oxford University Press, Oxford 2006, S. 10 ff.

- ↑ Dynamismus – Wiktionary. Abgerufen am 16. April 2021.

- ↑ Chris Eliasmith: How to Build a Brain: A Neural Architecture for Biological Cognition. Oxford University Press, 2013, ISBN 978-0-19-979454-6.

- ↑ Heinz von Foerster u.a: Einführung in den Konstruktivismus. Veröffentlichungen der Carl-Friedrich-von-Siemens-Stiftung, 5; München, Zürich: Piper-TB, 2006.

- ↑ Humberto R. Maturana und Francesco J. Varela: Der Baum der Erkenntnis. Die biologischen Wurzeln menschlichen Erkennens. Frankfurt 2010, S. 175ff.

- ↑ Maturana und Varela, 2010, S. 226.

- ↑ Maturana und Varela, 2010, S. 251

- ↑ Hardcastle, V.G. (1998). “The binding problem”. In W. Bechtel & G. Graham (eds.), A Companion to Cognitive Science (pp. 555-565). Blackwell Publisher, Malden/MA, Oxford/UK.

- ↑ Hummel, J. (1999). “Binding problem”. In: R.A. Wilson & F.C. Keil, The MIT Encyclopedia of the Cognitive Sciences (pp. 85-86). Cambridge, MA, London: The MIT Press.

- ↑ Malsburg, C. von der (1999). “The what and why of binding: The modeler's perspective.” Neuron. 24: 95-104.

- ↑ Gray, C. M. & Singer, W. (1989). “Stimulus-specific neuronal oscillations in orientation columns of cat visual cortex”. Proceedings of the National Academy of Sciences of the United States of America. 86: 1698-1702.

- ↑ Singer, W. (1999b). “Neuronal synchrony: A versatile code for the definition of relations.” Neuron. 24: 49-65.

- ↑ Singer, W. & A. Lazar. (2016). „Does the cerebral cortex exploit high-dimensional, non-linear dynamics for information processing?“ Frontiers in Computational Neuroscience.10: 99.

- ↑ Singer, W. (2018). „Neuronal oscillations: unavoidable and useful?“ European Journal of Neuroscience. 48: 2389-2399.

- ↑ Maurer, H. (2021). Cognitive science: Integrative synchronization mechanisms in cognitive neuroarchitectures of the modern connectionism. CRC Press, Boca Raton/FL, ISBN 978-1-351-04352-6. doi:10.1201/9781351043526

- ↑ Maurer, H. (2016). „Integrative synchronization mechanisms in connectionist cognitive Neuroarchitectures“. Computational Cognitive Science. 2: 3. doi:10.1186/s40469-016-0010-8

- ↑ Marcus, G.F. (2001). The algebraic mind. Integrating connectionism and cognitive science. Bradford Book, The MIT Press, Cambridge, ISBN 0-262-13379-2.

- ↑ https://www.tu-darmstadt.de/studieren/studieninteressierte/studienangebot_studiengaenge/studiengang_196608.de.jsp

- ↑ https://www.uni-potsdam.de/de/studium/studienangebot/bachelor/ein-fach-bachelor/kognitionswissenschaft, https://www.uni-potsdam.de/de/studium/studienangebot/masterstudium/master-a-z/cognitive-science

- ↑ https://www.tu-chemnitz.de/physik/SEKO/infobsc.html

Auf dieser Seite verwendete Medien

Autor/Urheber:

André Karwath aka Aka

, Lizenz: CC BY-SA 2.5Diese Animation zeigt die Lösung des Spiels "Türme von Hanoi" mit vier Scheiben. Es gibt auch eine Version mit drei Scheiben.

Autor/Urheber: Ulrich Hansen, Germany (Journalist)., Lizenz: CC BY-SA 3.0

Joseph Weizenbaum (emeritierter Professor der Informatik des MIT). Aufgenommen auf dem Balkon seines Apartments in Berlin, Deutschland.

Autor/Urheber:

- abgeleitetes Werk: TripleWhy / Turingmaschine.png: Zap

1-Band Turingmaschine

Autor/Urheber: Diese Datei enthält Elemente von, Lizenz: CC BY-SA 3.0

Based on Cognitive science heptagram.svg, originally adapted from: * Miller, George A (2003). "The cognitive revolution: a historical perspective". TRENDS in Cognitive Sciences 7. This revised adaptation more accurately reflects the image as presented by Miller.

Autor/Urheber: Marcello Casal Jr/ABr, Lizenz: CC BY 3.0 br

Noam Chomsky at World Social Forum 2003.

Autor/Urheber: Dake, Mysid, Lizenz: CC BY 1.0

A simplified view of an artificial neural network.