Künstliche Intelligenz in der Medizin

Künstliche Intelligenz in der Medizin ist ein stark wachsender Teilbereich der künstlichen Intelligenz (KI), bei dem digital vorliegende Informationen ausgewertet werden, um möglichst aussagekräftige Diagnosen zu stellen und bzw. oder optimierte Therapien vorzuschlagen[1].

Diagnostik

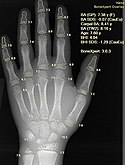

Computer Vision für bildgebende Diagnostik

Künstliche Intelligenz spielt eine Rolle in der bildgebenden Diagnostik. Die Auswertung von Bildern mit statistischen und lernenden Methoden wird auch unter dem Fachbereich Radiomics zusammengefasst. Dabei werden Ärzte im Rahmen von Entscheidungsunterstützungssystemen unterstützt. Durch den Einsatz dieser Methoden ist es beispielsweise möglich, den Typ der Krebszellen genauer zu bestimmen, da die Unterscheidungsmerkmale oft schwer mit dem menschlichen Auge zu erkennen sind. Dies ist im Rahmen der Präzisionsmedizin wichtig, um eine zielgerichtete Therapie vorzuschlagen. Je nach Typ des Krebs sind teils unterschiedliche Therapien notwendig oder sinnvoll. Eingesetzt wird Radiomics etwa zur Klassifizierung von Tumoren unter anderem in Lunge, Brust, Gehirn und Haut.[2]

Onkologie

Die bisher größte, web-basierte und international durchgeführte Studie zur automatisierten Hautkrebsdiagnose unter Leitung der Medizinischen Universität Wien verglich 511 Mediziner aus 63 Ländern gegen 139 Algorithmen (zumeist basierend auf neuronalen Netzwerken, CNN) in der Erkennung von Hautkrebs an dermatoskopischen Bildern.[3] Im Gegensatz zu anderen Studien mussten nicht nur zwei Arten von Hautveränderungen (Muttermale und Melanome) erkannt werden, sondern die sieben häufigsten pigmentierten Hautveränderungen.[4] In der Studie zeigte sich – im experimentellen Setting – nicht nur eine klare Überlegenheit der besten Algorithmen, sondern auch, dass bereits „durchschnittliche“ Maschinen ähnlich gut oder besser Kategorien erkennen konnten als Mediziner.

In einer internationalen Studie der Universität Heidelberg, bei der 58 Dermatologen aus 17 Ländern gegen ein faltendes neuronales Netzwerk im Vergleichstest antraten, fand sich ebenfalls eine Überlegenheit des neuronalen Netzwerks zu Dermatologen in der Erkennung von Melanomen, jedoch nicht, sobald Dermatologen zusätzliche Informationen wie Alter, Geschlecht und Lage der Läsion erhielten. Die Richtig-negativ-Rate lag bei den Dermatologen jedoch mit 75,7 Prozent deutlich über der des Netzwerkes, das nur 63,8 Prozent der ungefährlichen Muttermale als solche erkannte. Die Forscher betonten, dass künstliche Intelligenz die Ärzte bei der Diagnose von Hautkrebs unterstützen, sie aber nicht ersetzen könne.[5] Es gibt weitere Studien in größeren bzw. internationalen Rahmen,[6][7][8] oder kleinen bzw. lokalen Rahmen.[9][10][11][12]

Obwohl die Meinung zu diesen Techniken auch bei Dermatologen großteils positiv scheint,[13] und sich erste Ergebnisse zum Vorteil der Kollaboration zwischen Mensch und Maschine zeigen,[14] mahnen einige Wissenschaftler und Kliniker zur Vorsicht bei der Anwendung dieser Techniken.[15][16] Viele Firmen arbeiten auch an der Kommerzialisierung dieser Projekte, manche auf Basis von Hardware wie Infrarot-Lasertrahlen,[17] manche auf Basis von Dermatoskopie,[18][19] Für Smartphones gibt es bereits seit Jahren eine Reihe häufig kostenpflichtiger Apps, die Hautkrebs anhand eines Fotos erkennen sollen, aber meist nicht auf neuen Techniken wie neuronalen Netzwerken basieren. Eine wissenschaftliche Aufarbeitung konnte zeigen, dass keine der getesteten Applikationen eine ausreichende Genauigkeit, und damit Nutzen für Patienten aufgewiesen hat.[20] Der Dermatologe und Versorgungsforscher Matthias Augustin sieht diese ebenfalls kritisch, da es zu Anwendungsfehlern und Falschdiagnosen kommen könnte, die Laien nicht richtig einschätzen könnten.[21]

In einem wissenschaftlichen Wettbewerb zur automatisierten Erkennung von Brustkrebszellen (Diagnose von Metastasen in Sentinel-Node-Biopsien) traten jeweils 32 Programme von 23 Teams gegen ein Team aus elf Pathologen an, die jeweils zwei Stunden Zeit zur Analyse von 129 Präparaten hatten. Eine Vergleichsgruppe bestand aus einem versierten Pathologen, der sich so viel Zeit nehmen durfte, wie er wollte, was allerdings nicht dem klinischen Alltag entspricht. Die Programme nutzten meist Convolutional Neural Networks. Sieben der Programme lieferten bessere Ergebnisse als die Gruppe der Pathologen. Die menschlichen Pathologen übersahen häufig Mikrometastasen, was den besseren Programmen nur selten passierte. Fünf der Programme waren sogar besser als der versierte Pathologe, der sich 30 Stunden Zeit für die Analyse nahm. Selbst dieser versierte Pathologe übersah ein Viertel der Mikrometastasen.[22]

Die Darmspiegelung gilt als die sicherste Methode, um bösartige Tumore in Mast- und Dickdarm frühzeitig zu erkennen. Jährlich erkranken 61.000 Menschen in Deutschland an Darmkrebs. Bei einer Darmspiegelung entfernt der Arzt alle verdächtigen Wucherungen, sog. Polypen, egal ob die Wucherung gut- oder bösartig ist. Ob es sich um einen bösartigen Tumor (sog. Adenom) handelt, kann erst später im Labor festgestellt werden. Im Herbst 2018 setzten japanische Gastroenterologen in einem klinischen Test eine KI ein, die auf die Erkennung von bösartigen Tumoren im Darm trainiert wurde. Die Trefferrate lag bei 93 Prozent. Dabei werden Bilder aus dem Darm in 500-facher Vergrößerung an eine KI übermittelt, die dann innerhalb einer Sekunde erkennen kann, ob es sich bei dem Polyp um einen gut- oder bösartigen Tumor handelt. Der Arzt erhält dann eine Rückmeldung über einen Ton oder über einen Hinweis auf dem Bildschirm. Die KI soll weiter trainiert werden, um die Erkennungsrate noch zu verbessern. Dann könnte die KI in den Routinebetrieb gehen.[23]

Neurologie

Wissenschaftler an der University of California in San Francisco haben im Herbst 2018 eine Pilotstudie mit tiefen, künstlichen neuronalen Netzen im Journal Radiology vorgestellt, die anhand von Gehirnscans eine Alzheimererkrankung im Schnitt sechs Jahre vor der finalen Diagnose erkennen können. Häufig werde Alzheimer von Ärzten erst dann diagnostiziert, wenn sich die ersten Symptome zeigen. Selbst erfahrenen Ärzten fällt es schwer, die bei Frühstadien auftretenden, kleinen Veränderungen im Gehirn zu erkennen und richtig einzuordnen. Deshalb könne die KI-gestützte Erkennung einen wichtigen Beitrag zur Früherkennung und damit zur Behandlung leisten. Das Netz erreichte eine Sensitivität von 100 %, bei einer Richtig-negativ-Rate von 82 %. Weitere Untersuchungen sollen folgen, um die Ergebnisse zu verifizieren.[24][25]

Pneumologie

Das Wiener KI-Labor Deep Insight veröffentlichte 2020 den Quellcode eines künstlichen neuronalen Netzwerkes, das darauf trainiert wurde, anhand von CT-Aufnahmen der Lunge zu klassifizieren, ob der Patient an COVID-19 leidet, sofern das Virus bereits die Lunge befallen hat. Das Netzwerk unterscheidet zwischen durch COVID-19 verursachte Veränderungen der Lunge, sonstigen pathologischen Befunden und Normalzustand.[26]

Ophthalmologie

In der Augenheilkunde konnte für KI-basierte Ansätze eine Überlegenheit gegenüber Fachspezialisten für verschiedenste klinisch-relevante Aufgaben nachgewiesen werden. Dies umfasst unter anderem das Erkennen von Diagnosen anhand von Netzhaut-Bildgebung, die Berechnung der idealen Linsenstärke vor grauer Star Operation, sowie das erkennen von systemischen Risikofaktoren (bspw. Blutdruck) anhand von ophthalmologischen Bildaufnahmen.[27] Im Direktvergleich zwischen Deep Learning und 13 menschlichen Spezialisten wurden 25.326 Fundus-Fotografien (Fotos des Augenhintergrundes) von Diabetikern einer diagnostischen Bewertung der Diabetischen Retinopathie unterzogen. Die Sensitivität des Neuronalen Netzwerks lag bei 0,97 (0,74 bei den Spezialisten) und die Spezifität bei 0,96 (0,98).[28] Das Projekt wurde als Nachweis herausragender menschlicher Leistungen in dem AI Index Report 2019 als Meilenstein gewürdigt.[29] 2021 zeigten sich in einer Hersteller-unabhängigen, vergleichenden Bewertung von Algorithmen in USA („head-to-head“) an Real-World-Daten von 310.000 Fundusfotografien zum Screening auf eine Diabetische Retinopathie erhebliche Unterschiede, sowohl bei der Sensitivität (51-86 %) als auch der Spezifität. Insgesamt 7 Algorithmen mussten gegen menschliche Augenspezialisten antreten, welche bereits in mehreren Ländern in Gebrauch waren, wobei einer eine FDA-Zulassung und mehrere eine CE-Kennzeichnung hatten.[30]

Interessanterweise konnte gezeigt werden, dass sich sogar das Geschlecht anhand von Farbfundusphotos mittels KI identifizieren lässt.[31] Dies galt unter Fachspezialisten zuvor als unmöglich. Folgearbeiten konnten zeigen, dass KI-Anwendungen das Geschlecht an subtilen Unterschieden des Verlaufs der Gefäße erkennen können.[32]

Kardiologie

In der Kardiologie sind Algorithmen in Gebrauch, die Langzeit-EKG's für einen Arzt auswerten und wichtige Rhythmusstörungen binnen Sekunden finden und auflisten. Für den medizinischen Laien gibt es niederschwellige mobile Anwendungen mit Algorithmen („Smart APP's“), welche die Pulsfrequenz mittels Photoplethysmographie messen können (ähnlich der Pulsoxymetrie). Hier sind Arrhythmien, besonders Vorhofflimmern, bedeutsam, weil damit das Schlaganfallrisiko steigt.[33]

Radiologie

Brustkrebs-Screening

Die Auswertung der Röntgenbilder durch Radiologen ist eine monotone, anstrengende, langwierige und fehleranfällige Arbeit.[34] Dies ist in Deutschland, in Österreich und teilweise in der Schweiz für Frauen ab 45 alle zwei Jahre Standard. Falsch-positive führen zu unnötigen Biopsien, Falsch-negative übersehen einen Brustkrebs im Frühstadium, in welchem noch eine Heilung möglich wäre. Bei zwei-jährlichen Untersuchungen sind liegen insbesondere diese falsch-Positiven ins Gewicht, die auf 50 % geschätzt werden und eine hohe psychologische Bedeutung haben, insbesondere, wenn sich hinterher histologisch ein gutartiger Befund ergibt. Durch die Digitalisierung in der Radiologie (PACS) liegen mittlerweile sehr viele Aufnahmen in Datenbanken, welche ein maschinelles Lernen (ML) ermöglicht haben.

Mehrere Projekte zeigen, dass es bei KI nicht immer darum geht, ob die Maschine besser ist als der Mensch, sondern

- dass der Arbeitsaufwand für die Befundung durch Ärzte um fast 20 % reduziert werden kann

- dass einfache Fälle von komplexen Fällen separiert werden können, welche dann ein Radiologen-Team gezielt manuell befundet

- ob bei Doppelbefundung (Qualitätsstandard in Deutschland und Österreich alle zwei Jahre), der „zweite Befunder“ durch ein KI ersetzt werden kann.

- durch Echtzeit-KI-Detektion die Raten von Falsch-Positiven bis zu 69 % gesenkt werden kann

Befundet hingegen eine KI Mammografien ohne Mithilfe eines Radiologen, so fand sich eine geringfügig verbesserte diagnostische Performance bei gleichbleibendem Zeitaufwand pro Bild.

Die Autoren der Studie[35] halten einen multimodalen Ansatz, bei dem nicht alleine die Maschine den Arzt ersetzt, für zukunftsweisend. Sie sehen den Radiologen als Beruf somit nicht gefährdet.

Geriatrie

Bei älteren Menschen sollen KI-Algorithmen die individuelle Eintrittswahrscheinlichkeit von Ereignissen – insbesondere Gefahrensituationen – vorhersagen. Dazu sollen Risiken erkannt werden, um dadurch die Pflegebedürftigen bzw. dessen Angehörige frühzeitig zu warnen. Das Ziel des Projekts KI@Home ist die Entwicklung eines selbstlernenden Systems für den Bereich altersgerechtes Wohnen.[36] Mithilfe von Sensoren und anderen Methoden der Datenerfassung, werden Vitalwerte und Verhaltensmuster von Probanden aufgezeichnet und ausgewertet.

Ein spezielles Verfahren ist die Ganganalyse.

In der Geriatrie sind KI-basierte Algorithmen in der Lage Sturz-relevante Parameter aus einer gängigen Videoaufnahme einer sich bewegenden Person abzuleiten. Den Entwicklern der App LINDERA gelang es, Gangparameter (u. a. Schrittlänge, Ganggeschwindigkeit) per Video über ein Smartphone mit ähnlicher oder besserer Präzision als dem Goldstandard unter Zuhilfenahme von KI zu bestimmen.[37] Bisherige Ganganalysen waren deutlich aufwendiger und erforderten klinische, apparative Methoden z. B. mit Sensoren bestückte „Teppiche“.

Um zu zeigen, dass solche Methoden alten Menschen einen Nutzen bringen, führt der Weg von der Bestimmung von Gangparametern zur Sturzhäufigkeit über randomisierte Studien, die bisher fehlen bzw. in Vorbereitung sind.

Mittels Ganganalyse könnten auch Alterskrankheiten wie Morbus Parkinson per Video, Telemedizin und/oder KI einen Innovationsschub bei der Therapie-Bewertung erhalten, indem man das Gangbild vor und nach Therapiebeginn analysiert.

Insgesamt ist diese Disziplin noch am Anfang, lt. einer Metaanalyse[38] sind die Bewertungsmetriken noch zu heterogen und es fehlen Standards.

Personalisierte Vorhersagen mittels Präzisionsmedizin

Mit Hilfe von statistischen Methoden können Studien für eine Gruppe von Menschen (z. B. gleiche Diagnose) sehr gut vorhersagen, ob ein Therapieverfahren wirksam ist oder nicht (z. B. ein neues Medikament). Ziel der Präzisionsmedizin (personalisierte Medizin) ist es, dies auf ein Individuum herunter zu brechen, von welchem man mehr Parameter kennt, z. B. Biomarker. Das beinhaltet auch ein Aussortieren von Personen, bei denen eine spezielle Therapie nicht hilft und deren Anwendung wegen Nebenwirkung sogar schädlich sein könnte und/oder unnötige Kosten verursacht. Einzelerfolge ohne Anwendung von künstlicher Intelligenz aus der Krebstherapie sind beschrieben, wobei auch eine kausale Beziehung zwischen Biomarker und Outcome besteht[39][40]. Beispielsweise konnte im August 2016 am Medical Institute der Universität Tokyo das Computerprogramm IBM Watson eine Fehldiagnose der Ärzte korrigieren. Die Ärzte diagnostizierten bei der Patientin eine akute myeloische Leukämie. Die Therapie blieb erfolglos, weswegen man Watson zu Rate zog. Die KI benötigte 10 Minuten, um die DNA der Frau mit 20 Millionen Krebsstudien abzugleichen. Watson erkannte eine sehr seltene Form der Leukämie, die bislang nur 41 Patienten betraf und heilbar ist.[41]

Große Hoffnung liegt in der durch Maschinelles Lernen gestützten Präzisionsmedizin: Allerdings können aus erkenntnistheoretischer Sicht daten-gesteuerte Vorhersagemodelle mit Maschinellem Lernen keine kausalen Schlussfolgerungen liefern, sondern nur statistische Korrelationen aufzeigen[42].

Dies könnte ein merkliches Hindernis sein, mittels künstlicher Intelligenz präzise individuelle Vorhersagen zu machen, trotz rapide wachsender Datensätze und ausgefeilterer Algorithmen.

Automatische Datenanalyse

Wissenschaftler der Universität Stanford haben im Januar 2018 eine KI vorgestellt, die mit einer Wahrscheinlichkeit von 90 Prozent bei unheilbar kranken Patienten aus den Krankendaten berechnen kann, ob diese innerhalb der nächsten 3 bis 12 Monate versterben werden. Dies könne unheilbar kranken Patienten helfen, die letzten Monate würdevoll und ohne aggressive Behandlungsmethoden und eventuell daheim unter Palliativversorgung zu verleben.[43]

Die Armbanduhr Apple Watch zeichnet unter anderem die Herzfrequenz eines Menschen auf. Apple gab bekannt, dass KIs mit einer Wahrscheinlichkeit von 85 Prozent aus der Analyse der Herzfrequenz Diabetes mellitus beim Träger der Armbanduhr feststellen können. Die Idee basiert auf der Framingham-Herzstudie, die bereits 2015 erkannte, dass man allein mit Hilfe der Herzfrequenz Diabetes diagnostizieren kann. Apple war es bereits früher schon gelungen, aus der Herzfrequenz einen abnormalen Herzrhythmus mit 97-prozentiger Wahrscheinlichkeit, Schlafapnoe mit 90 Prozent, Hypertonie (Bluthochdruck) mit 82 Prozent zu erkennen.[44]

Sprachverarbeitung

Forscher der Mount Sinai School of Medicine demonstrierten im Januar 2018, wie aus psychologischen Gesprächsprotokollen mit Jugendlichen erkennbar ist, ob diese in den nächsten zwei Jahren an einer Psychose erkranken. Die natürliche Sprachverarbeitung half, in standardisierten Tests bis zu 83 Prozent Genauigkeit zu erreichen, etwa anhand unorganisierter Gedankengänge, umständlicher Formulierungen, unklarer Assoziationen oder einer reduzierte Sprach-Komplexität. Die subtilen Unterschiede seien nach einem Training mit vielen solchen Gesprächen zu erkennen.[45][46]

Forscher des MIT stellten im September 2018 eine KI vor, die anhand von gesprochenem Text oder geschriebenem Text eine Depression bei Patienten diagnostizieren kann. An sich stellen Ärzte und Psychologen dem Patienten Fragen zu Lebensgewohnheiten, Verhaltensweisen und Befindlichkeiten, um aus Antworten die Depression zu diagnostizieren. Nach einem Training mit solchen Interviews erkannte das Programm auch anhand von Alltagsgesprächen eine Depression mit einer Trefferquote von 83 Prozent – und bei der Einordnung der Schwere der Depression auf einer Skala von 0 bis 27 mit einer 71 Prozent Trefferquote. Die KI könnte Ärzte bei unterstützen oder als App Benutzer permanent überwachen um im Notfall zu alarmieren. Die Forscher wollen aus der Sprache künftig auch eine Demenz erkennen.[47]

Die Gesundheitsapp Babylon Health soll laut Hersteller mit einem Sprachsystems (Chatbot), basierend auf einer KI, eine Diagnose im Gespräch mit Patienten erstellen können, die etwa zehnmal treffsicherer als Diagnosen eines Hausarztes sei. Die Entwicklung der App wurde auch vom britischen Gesundheitssystems mitfinanziert. Ziel war es, damit Kosten zu senken. Obwohl die App Arztbesuche deutlich reduzieren soll, fanden Patienten schnell heraus, wie man mit der App durch falsche Symptombeschreibungen schneller Arzttermine erhält.[48]

Die App Ada des Berliner Unternehmens Ada Health unterstützt bei Diagnosenstellungen anhand der Symptom-Beschreibung mit einer KI. Laut Hersteller soll dies der Qualität gut ausgebildeter westlicher Ärzte entsprechen. Die App Ada sandte unerlaubt Marketing-Unternehmen wie Amplitude und Adjust mit Hauptsitz San Francisco (USA) sowie im Verlauf der App-Nutzung regelmäßig Facebook.com personenbezogene Daten, auch wenn man kein Facebook-Konto hat.[49] Die App wurde vom MIT ausgezeichnet und wird von der Bill & Melinda-Gates-Stiftung gefördert. 2019 verkündete Ada Health eine Kooperation mit Sutter Health. Insbesondere in Entwicklungsländern, wo es an medizinischem Personal mangelt, kann die App helfen, ein Gesundheitssystem aufzubauen.[50][51]

Ada und Babylon Health werden Symptom-Checker genannt , welche oft statt KI auch klassische statistische Verfahren (Entscheidungsbäume, Korrelationen) verwenden.

Kosteneffektivität

Die Kosteneffektivität der künstlichen Intelligenz in der Diagnostik wurde an drei verschiedenen Krankheitsbildern in drei verschiedenen Nationen mit unterschiedlichen Gesundheitssystem modelliert. Dabei wurde das Screening auf Maligne Melanome, Karies-Röntgenuntersuchung und Fundusfotos bei Diabetischer Retinopathie mittels Künstlicher Intelligenz und mittels herkömmlicher Verfahren über einen lebenslangen Zeitraum mit konventionellen Verfahren verglichen. Ergebnisparameter waren die jeweiligen Kosten (bei Einzelabrechnung) und die Qualitäts-korrigierten Lebensjahre (QALY's) bzw. die Zahnerhaltung

Als Resultat zeigte sich, dass sowohl die Kosten wie auch die Patienten-relevanten Ergebnisse im Langzeit-Vergleich ähnlich waren. Geringe Vorteile zeigten sich bei der Zahnerhaltung[52].

Behördlich erteilte Zulassungen

Geräte oder Software, die künstliche Intelligenz verwenden müssen in Europa als Medizinprodukte eine CE-Kennzeichnung erhalten und in den USA durch die FDA zugelassen sein. Ein Vergleich zwischen USA und Europa in den Jahren 2015 bis 2020 erbrachte, eine schnell zunehmende Zahl von Zulassungen, wobei die CE-Markierung zahlenmäßig leicht dominiert (2019 USA 79, EU 100). Oft erfolgt die CE-Markierung vor der FDA-Zulassung, was auf ein weniger rigoroses Verfahren hindeuten könnte. Das Schwergewicht liegt bei der Radiologie. Nur 15 % der Produkte wenden sich direkt an Privatpersonen (Patienten), der Rest an Fachpersonal (Ärzte). In diesem Zeitraum entfallen nur 1 % der Zulassungen auf die höchsten Risikoklassen, z. B. solche für die Diagnose von Brustkrebs[53].

Mehr noch in Europa als in Amerika finden die Autoren der Studie einen Mangel an Transparenz in der Gerätebeschreibung und dem Prozess der Bewertung. Sie spiegelt die ethische Verantwortung der Regulierer genauso wie der Hersteller wider. Auch wird eine öffentlich zugängliche Datenbank für CE-markierte Geräte und Software angemahnt. Die Zulassungspraxis digitaler Gesundheitsanwendungen wurde in einer weiteren Studie als ungenügend befunden und als „Regulatorische Lücke“ bezeichnet.[54]

Kritik und Streitfragen

Es ist umstritten, ob die hohe Treffergenauigkeit der KI etwa zur Diagnose von Krankheiten, die in manchen Studien angegeben wurden, in der Praxis gültig sind. Die Werte beziehen sich in der Regel auf vorher festgelegte, mitunter nicht repräsentative historische Datensätze. Beispielhaft wird eine Studie von Googles Tochterfirma DeepMind zur automatisierten Vorhersage von Nierenversagen kritisiert, die auf einem Datensatz durchgeführt wurde, der nur zu 6 % von weiblichen Patienten stammte. Die fehlende Variation in den Datensätzen könnte zu Computerprogrammen führen, die in ihrer Generalisierung stark eingeschränkt sind und in realen Einsatzszenarien nicht die erwünschte Genauigkeit liefern.[55]

Die Behandlungsvorschläge von IBM Watson können fehlerhaft sein, etwa, wenn zu wenig Trainingsdaten zur Verfügung stehen. Entsprechende Berichte über fehlerhafte Empfehlungen, deren Anwendung die Patienten gefährde, wurden 2018 von einem Medizinfachportal veröffentlicht. Die Fehlfunktion soll laut IBM in einer späteren Version behoben worden sein.[56]

Datenschutz und Privatheit

Da künstliche Intelligenz und maschinelles Lernen große Datenmengen beim Training benötigen und medizinische Daten als besonders sensibel gelten, wird dem Datenschutz große Bedeutung beigemessen.

Beim Federated Learning und Swarm learning wird der Algorithmus nicht zentral trainiert, sondern an lokalen Institutionen (z. B. Krankenhäusern), wo die Daten geschützt liegen bleiben. Außerdem kann dem Besitzer eines Modells (Firma) besser garantiert werden, dass sein Modell nicht missbraucht, gestohlen oder verändert wird.[57][58]

Erklärbarkeit

Der Nutzer möchte die Gründe für eine algorithmische Entscheidung verstehen. Bei künstlicher Intelligenz und maschinellem Lernen sind Algorithmen oft komplett undurchsichtig („Black Box“), typischerweise bei neuronalen Netzwerken, insbesondere Deep Learning.[55] Um dem entgegenzuwirken, entwickelte sich das Feld Explainable AI.[59] Im Gesundheitsbereich werden vertrauenswürdige Modellentwickler, umfangreiche externe Validierung mittels Studien und standardisierte Bewertungsverfahren diskutiert.[60]

Boris Babic von der University of Toronto wendet ein, dass Explainable AI oftmals nur post-hoc Erklärungen für Black-Box-Algorithmen liefern würden. Diese Erklärungen seien nicht zuverlässig und könnten den Anwender in die Irre führen. Echte White-Box-Algorithmen, die tatsächlich nachvollziehbare Erklärungen liefern, seien hingegen in ihrer Komplexität deutlich beschränkt und daher für viele Anwendungsfälle kaum geeignet. Er hält es daher für einen Fehler, die Erklärbarkeit von Algorithmen etwa als Zulassungsvoraussetzung vorzuschreiben, da dies kaum Vorteile biete, dafür aber Innovationen bremse und zur Anwendung von Algorithmen mit geringerer Genauigkeit führe. Stattdessen sollten Algorithmen stärker in klinischen Studien getestet werden, um deren Effektivität und Sicherheit zu gewährleisten.[61][62]

Pharmaforschung

In der Pharmaforschung hat sich das automatisierte Hochdurchsatz-Screening als Methode etabliert, sogenannte Hits und damit Kandidaten für Leitstrukturen zu finden. Britische Forscher der Universität Cambridge entwickelten die Automatisierung weiter. Der Forschungsroboter „Eve“, der 2015 in Journal of the Royal Society Interface vorgestellt wurde, verwendet statistische Modelle und maschinelles Lernen und produziert und testet damit Annahmen, prüft Beobachtungen, führt Experimente aus, interpretiert Ergebnisse, ändert Hypothesen und wiederholt dies immer wieder. Dadurch könne der Roboter vielversprechende Substanzen vorhersagen und damit das Finden von Leitstrukturen effizienter machen.[63][64] Mit Hilfe dieses Roboters fanden die Forscher 2018 heraus, dass Triclosan, das auch in Zahnpasta verwendet wird, Malaria-Infektionen in zwei kritischen Stadien, nämlich dem Befall der Leber und des Bluts, bekämpfen könnte. Mit der Entdeckung durch die KI könnte nun ein neues Medikament entwickelt werden.[65]

Literatur

- Eric Topol: Deep Medicine Künstliche Intelligenz in der Medizin, mitp Verlags GmbH Frechen 2020 ISBN 978-3-7475-0095-8

Weblinks

- Künstliche Intelligenz in der Medizin: Arztunterstützend, nicht arztersetzend, Ärzteblatt vom 21. November 2017

- Künstliche Intelligenz in der Medizin, AI in Medicine, Deutsches Forschungszentrum für Künstliche Intelligenz, 1. Januar 2018

Einzelnachweise

- ↑ Jeffrey David Iqbal, Rasita Vinay: Are we ready for Artificial Intelligence in Medicine? In: Swiss Medical Weekly. Nr. 19, 19. Mai 2022, doi:10.4414/smw.2022.w30179 (smw.ch [abgerufen am 26. August 2022]).

- ↑ Alanna Vial, David Stirling, Matthew Field, Montserrat Ros, Christian Ritz: The role of deep learning and radiomic feature extraction in cancer-specific predictive modelling: a review. In: Translational Cancer Research. Band 7, Nr. 3, 6. Juli 2018, ISSN 2219-6803, S. 803–816, doi:10.21037/21823 (amegroups.com [abgerufen am 9. Dezember 2018]).

- ↑ P Tschandl, N Codella, BN Akay, G Argenziano, RP Braun, H Cabo, D Gutman, A Halpern, B Helba, R Hofmann-Wellenhof, A Lallas, J Lapins, C Longo, J Malvehy, MA Marchetti, A Marghoob, S Menzies, A Oakley, J Paoli, S Puig, C Rinner, C Rosendahl, A Scope, C Sinz, HP Soyer, L Thomas, I Zalaudek, H Kittler: Comparison of the accuracy of human readers versus machine-learning algorithms for pigmented skin lesion classification: an open, web-based, international, diagnostic study. In: The Lancet. Oncology. 20. Jahrgang, Nr. 7, Juli 2019, S. 938–947, doi:10.1016/S1470-2045(19)30333-X, PMID 31201137.

- ↑ P Tschandl, C Rosendahl, H Kittler: The HAM10000 dataset, a large collection of multi-source dermatoscopic images of common pigmented skin lesions. In: Scientific data. 5. Jahrgang, 14. August 2018, S. 180161, doi:10.1038/sdata.2018.161, PMID 30106392.

- ↑ HA Haenssle, C Fink, R Schneiderbauer, F Toberer, T Buhl, A Blum, A Kalloo, ABH Hassen, L Thomas, A Enk, L Uhlmann, Groups. Reader study level-I and level-II: Man against machine: diagnostic performance of a deep learning convolutional neural network for dermoscopic melanoma recognition in comparison to 58 dermatologists. In: Annals of oncology: official journal of the European Society for Medical Oncology. 29. Jahrgang, Nr. 8, 1. August 2018, S. 1836–1842, doi:10.1093/annonc/mdy166, PMID 29846502.

- ↑ P Tschandl, C Rosendahl, BN Akay, G Argenziano, A Blum, RP Braun, H Cabo, JY Gourhant, J Kreusch, A Lallas, J Lapins, A Marghoob, S Menzies, NM Neuber, J Paoli, HS Rabinovitz, C Rinner, A Scope, HP Soyer, C Sinz, L Thomas, I Zalaudek, H Kittler: Expert-Level Diagnosis of Nonpigmented Skin Cancer by Combined Convolutional Neural Networks. In: JAMA dermatology. 155. Jahrgang, Nr. 1, 1. Januar 2019, S. 58–65, doi:10.1001/jamadermatol.2018.4378, PMID 30484822.

- ↑ MA Marchetti, NCF Codella, SW Dusza, DA Gutman, B Helba, A Kalloo, N Mishra, C Carrera, ME Celebi, JL DeFazio, N Jaimes, AA Marghoob, E Quigley, A Scope, O Yélamos, AC Halpern, Collaboration. International Skin Imaging: Results of the 2016 International Skin Imaging Collaboration International Symposium on Biomedical Imaging challenge: Comparison of the accuracy of computer algorithms to dermatologists for the diagnosis of melanoma from dermoscopic images. In: Journal of the American Academy of Dermatology. 78. Jahrgang, Nr. 2, Februar 2018, S. 270–277.e1, doi:10.1016/j.jaad.2017.08.016, PMID 28969863.

- ↑ HA Haenssle, C Fink, F Toberer, J Winkler, W Stolz, T Deinlein, R Hofmann-Wellenhof, A Lallas, S Emmert, T Buhl, M Zutt, A Blum, MS Abassi, L Thomas, I Tromme, P Tschandl, A Enk, A Rosenberger, Groups. Reader Study Level I and Level II: Man against machine reloaded: performance of a market-approved convolutional neural network in classifying a broad spectrum of skin lesions in comparison with 96 dermatologists working under less artificial conditions. In: Annals of oncology: official journal of the European Society for Medical Oncology. 31. Jahrgang, Nr. 1, Januar 2020, S. 137–143, doi:10.1016/j.annonc.2019.10.013, PMID 31912788.

- ↑ P Tschandl, H Kittler, G Argenziano: A pretrained neural network shows similar diagnostic accuracy to medical students in categorizing dermatoscopic images after comparable training conditions. In: The British journal of dermatology. 177. Jahrgang, Nr. 3, September 2017, S. 867–869, doi:10.1111/bjd.15695, PMID 28569993.

- ↑ SS Han, MS Kim, W Lim, GH Park, I Park, SE Chang: Classification of the Clinical Images for Benign and Malignant Cutaneous Tumors Using a Deep Learning Algorithm. In: The Journal of investigative dermatology. 138. Jahrgang, Nr. 7, Juli 2018, S. 1529–1538, doi:10.1016/j.jid.2018.01.028, PMID 29428356.

- ↑ C Yu, S Yang, W Kim, J Jung, KY Chung, SW Lee, B Oh: Acral melanoma detection using a convolutional neural network for dermoscopy images. In: PloS one. 13. Jahrgang, Nr. 3, 2018, S. e0193321, doi:10.1371/journal.pone.0193321, PMID 29513718.

- ↑ A Esteva, B Kuprel, RA Novoa, J Ko, SM Swetter, HM Blau, S Thrun: Dermatologist-level classification of skin cancer with deep neural networks. In: Nature. 542. Jahrgang, Nr. 7639, 2. Februar 2017, S. 115–118, doi:10.1038/nature21056, PMID 28117445.

- ↑ S Polesie, M Gillstedt, H Kittler, A Lallas, P Tschandl, I Zalaudek, J Paoli: Attitudes towards artificial intelligence within dermatology: an international online survey. In: The British journal of dermatology. 17. Januar 2020, doi:10.1111/bjd.18875, PMID 31953854.

- ↑ SS Han, I Park, W Lim, MS Kim, GH Park, JB Chae, CH Huh, SE Chang, JI Na: Augment Intelligence Dermatology: Deep Neural Networks Empower Medical Professionals in Diagnosing Skin Cancer and Predicting Treatment Options for 134 Skin Disorders. In: The Journal of investigative dermatology. 5. Februar 2020, doi:10.1016/j.jid.2020.01.019, PMID 32243882.

- ↑ A Lallas, G Argenziano: Artificial intelligence and melanoma diagnosis: ignoring human nature may lead to false predictions. In: Dermatology practical & conceptual. 8. Jahrgang, Nr. 4, Oktober 2018, S. 249–251, doi:10.5826/dpc.0804a01, PMID 30479851.

- ↑

- ↑ Ein Berliner Startup erkennt Hautkrebs besser als ein Arzt gruenderszene.de vom 13. Februar 2018

- ↑ DermEngine AI

- ↑ FotoFinder MoleAnalyzer

- ↑ A Ngoo, A Finnane, E McMeniman, JM Tan, M Janda, HP Soyer: Efficacy of smartphone applications in high-risk pigmented lesions. In: The Australasian journal of dermatology. 59. Jahrgang, Nr. 3, August 2018, S. e175-e182, doi:10.1111/ajd.12599, PMID 28240347.

- ↑ NDR: Wie nützlich sind „Hautkrebs-Apps“? (ndr.de [abgerufen am 1. Dezember 2018]).

- ↑ Arzt versus Computer: Wer erkennt Brustkrebsmetastasen am besten? aerzteblatt.de vom 13. Dezember 2017

- ↑ DARMKREBSVORSTUFEN MIT KÜNSTLICHER INTELLIGENZ ERKENNEN internisten-im-netz.de vom 8. Oktober 2018

- ↑ Yiming Ding, Jae Ho Sohn, Michael G. Kawczynski, Hari Trivedi, Roy Harnish: A Deep Learning Model to Predict a Diagnosis of Alzheimer Disease by Using 18F-FDG PET of the Brain. In: Radiology. 6. November 2018, ISSN 0033-8419, S. 180958, doi:10.1148/radiol.2018180958 (rsna.org [abgerufen am 1. Dezember 2018]).

- ↑ Künstliche Intelligenz erkennt Alzheimer früher als Ärzte. In: BR24. (br.de [abgerufen am 1. Dezember 2018]).

- ↑ heise online: Künstliche Intelligenz diagnostiziert COVID-19 anhand von CT. Abgerufen am 16. April 2020.

- ↑ Pfau M, Walther G, von der Emde L, Berens P, Faes L, Fleckenstein M, Heeren TFC, Kortüm K, Künzel SH, Müller PL, Maloca PM, Waldstein SM, Wintergerst MWM, Schmitz-Valckenberg S, Finger RP, Holz FG: Artificial intelligence in ophthalmology: Guidelines for physicians for the critical evaluation of studies. In: Ophthalmologe. 117. Jahrgang, Nr. 10, Oktober 2020, S. 973–988, doi:10.1007/s00347-020-01209-z, PMID 32857270.

- ↑ Ruamviboonsuk, P., Krause, J., Chotcomwongse, P. et al. Deep learning versus human graders for classifying diabetic retinopathy severity in a nationwide screening program. npj Digit. Med. 2, 25 (2019). doi:10.1038/s41746-019-0099-8

- ↑ AI Index 2019. Abgerufen am 14. Januar 2021 (englisch).

- ↑ A. Y. Lee et al.: Multicenter, Head-to-Head, Real-World Validation Study of Seven Automated Artificial Intelligence Diabetic Retinopathy Screening Systems. In: Diabetes Care 2021; 44: S. 1168–1175, doi:10.2337/dc20-1877

- ↑ Poplin R, Varadarajan AV, Blumer K, Liu Y, McConnell MV, Corrado GS, Peng L, Webster DR: Prediction of cardiovascular risk factors from retinal fundus photographs via deep learning. In: Nat Biomed Eng. 2. Jahrgang, Nr. 3, März 2018, S. 158–164, doi:10.1038/s41551-018-0195-0, PMID 31015713.

- ↑ Dieck S, Ibarra M, Moghul I, Yeung MW, Pantel JT, Thiele S, Pfau M, Fleckenstein M, Pontikos N, Krawitz PM: Factors in Color Fundus Photographs That Can Be Used by Humans to Determine Sex of Individuals. In: Transl Vis Sci Technol. 9. Jahrgang, Nr. 7, Juni 2020, S. 8, doi:10.1167/tvst.9.7.8, PMID 32832215, PMC 7414790 (freier Volltext).

- ↑ Zippel-Schultz et al. Künstliche Intelligenz in der Kardiologie, Herzschr Elektrophys 2021 · 32:89–98 doi.org/10.1007/s00399-020-00735-2

- ↑ KI erkennt Brustkrebs: Selbstlernendes System erkennt Tumore in Mammografie-Aufnahmen so gut wie ein Radiologe. 16. März 2018, abgerufen am 2. Juli 2019.

- ↑ Batchu et al. Review of Applications of Machine Learning in Mammography and Future Challenges; Oncology 2021 doi:10.1159/000515698

- ↑ Willkommen auf der Projektseite von KI@Home

- ↑ Arash Azhand, Sophie Rabe, Swantje Müller, Igor Sattler, Anika Heimann-Steinert: Algorithm based on one monocular video delivers highly valid and reliable gait parameters. In: Scientific Reports. 11, 2021, doi:10.1038/s41598-021-93530-z.

- ↑ Avishek Choudhury, Emily Renjilian, Onur Asan: Use of machine learning in geriatric clinical care for chronic diseases: a systematic literature review JAMIA Open, 3, 2020, 459–471 doi:10.1093/jamiaopen/ooaa034

- ↑ Stellungnahme Vorstand Bundesärztekammer: Präzisionsmedizin: Bewertung unter medizinisch-wissenschaftlichen und ökonomischen Aspekten; Deutsches Ärzteblatt (2020) doi:10.3238/baek sn praezision 2020;

- ↑ Wolf-Dieter Ludwig, Möglichkeiten und Grenzen der stratifizierenden Medizin am Beispiel von prädiktiven Biomarkern und ,,zielgerichteten‘‘ medikamentösen Therapien in der Onkologie; Z. Evid. Fortbild. Qual. Gesundh. wesen (ZEFQ) 106 (2012) 11–22

- ↑ KI rettet Patientin das Leben, weil sie die Fehldiagnose der Ärzte korrigiert vice.com vom 10. August 2016

- ↑ Jack Wilkinson et al.: Time to reality check the promises of machine learning-powered precision medicine. Lancet Digital Health 2020; doi:10.1016/S2589-7500(20)30200-4

- ↑ Künstliche Intelligenz soll Todeszeitpunkt von Patienten vorhersagen. Abgerufen am 2. Juli 2019.

- ↑ Studie: Apple Watch erkennt Diabetes mit 85 Prozent Genauigkeit. 7. Februar 2018, archiviert vom Original am 13. Februar 2018; abgerufen am 2. Juli 2019.

- ↑ KI kann Psychosen bei Jugendlichen frühzeitig erkennen futurezone.de vom 23. Januar 2018

- ↑ Cheryl M. Corcoran, Facundo Carrillo, Diego Fernández-Slezak, Gillinder Bedi, Casimir Klim: Prediction of psychosis across protocols and risk cohorts using automated language analysis. In: World Psychiatry. Band 17, Nr. 1, 19. Januar 2018, ISSN 1723-8617, S. 67–75, doi:10.1002/wps.20491, PMID 29352548.

- ↑ Künstliche Intelligenz soll Depressionen an Sprechweise erkennen. 6. September 2018, abgerufen am 2. Juli 2019.

- ↑ Diese App sollte den Arztbesuch überflüssig machen – doch die Nutzer bewirkten das Gegenteil. 17. Dezember 2017, archiviert vom Original am 21. Dezember 2017; abgerufen am 2. Juli 2019. Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis.

- ↑ Massive Datenschutzmängel in der Gesundheits-App Ada. (Nicht mehr online verfügbar.) 10. Oktober 2019, archiviert vom Original am 11. Oktober 2019; abgerufen am 10. Oktober 2019. Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis.

- ↑ „Wir geben Millionen Menschen medizinischen Rat“. 10. Oktober 2018, abgerufen am 2. Juli 2019.

- ↑ Nachgefragt zum Kongress eHealth Europe in Freiburg. Archiviert vom Original am 3. Juli 2019; abgerufen am 2. Juli 2019.

- ↑ Jesus Gomez Rossi et al.: Cost-effectiveness of Artificial Intelligence as a Decision-Support System Applied to the Detection and Grading of Melanoma, Dental Caries, and DiabeticRetinopathy In: JAMA Network Open. 2022;5(3) doi:10.1001/jamanetworkopen.2022.0269

- ↑ UJ Muehlematter, P Daniore, KN Vokinger Approval of artificial intelligence and machine learning-based medical devices in the USA and Europe (2015–20): a comparative analysis Lancet Digital Health (2021) doi:10.1016/S2589-7500(20)30292-2, PMID 33478929

- ↑ Jeffrey David Iqbal, Nikola Biller-Andorno: The regulatory gap in digital health and alternative pathways to bridge it. In: Health Policy and Technology. Band 11, Nr. 3, 1. September 2022, ISSN 2211-8837, S. 100663, doi:10.1016/j.hlpt.2022.100663.

- ↑ a b Michael Moorstedt: Die blinden Flecken der künstlichen Intelligenzen. In: sueddeutsche.de. 11. August 2019, ISSN 0174-4917 (sueddeutsche.de [abgerufen am 13. August 2019]).

- ↑ KI gegen Krebs: Kritik an IBM Watson wegen „gefährlichen Empfehlungen“. In: derStandard.at. Abgerufen am 9. Dezember 2018.

- ↑ Schultze J et al. (2021): Swarm Learning for decentralized and confidential clinical machine learning. Nature. doi:10.1038/s41586-021-03583-3

- ↑ Kaissis G, Ziller A et al. (2021): End-to-end privacy preserving deep learning on multi-institutional medical imaging. Nature Machine Intelligence. doi:10.1038/s42256-021-00337-8

- ↑ Pantelis Linardatos, Vasilis Papastefanopoulos, Sotiris Kotsiantis: Explainable AI: A Review of Machine Learning Interpretability Methods. In: Entropy. Band 23, Nr. 1, 25. Dezember 2020, ISSN 1099-4300, S. 18, doi:10.3390/e23010018, PMID 33375658, PMC 7824368 (freier Volltext).

- ↑ Aniek F. Markus, Jan A. Kors, Peter R. Rijnbeek: The role of explainability in creating trustworthy artificial intelligence for health care: A comprehensive survey of the terminology, design choices, and evaluation strategies. In: Journal of Biomedical Informatics. Band 113, Januar 2021, S. 103655, doi:10.1016/j.jbi.2020.103655.

- ↑ Boris Babic, Sara Gerke, Theodoros Evgeniou, I. Glenn Cohen: Beware explanations from AI in health care. In: Science. Band 373, Nr. 6552, 16. Juli 2021, ISSN 0036-8075, S. 284–286, doi:10.1126/science.abg1834.

- ↑ Boris Babic, Sara Gerke: Explainable artificial intelligence: Easier said than done. In: STAT. 21. Juli 2021, abgerufen am 5. September 2021 (amerikanisches Englisch).

- ↑ Kevin Williams, Elizabeth Bilsland, Andrew Sparkes, Wayne Aubrey, Michael Young: Cheaper faster drug development validated by the repositioning of drugs against neglected tropical diseases. In: Journal of The Royal Society Interface. Band 12, Nr. 104, 6. März 2015, ISSN 1742-5689, S. 20141289, doi:10.1098/rsif.2014.1289, PMID 25652463.

- ↑ Artificially intelligent robot scientist 'Eve' could boost search for new drugs. (phys.org [abgerufen am 1. Dezember 2018]).

- ↑ AI robot finds ingredient in toothpaste may help fight malaria. In: The Independent. (independent.co.uk [abgerufen am 1. Dezember 2018]).

Auf dieser Seite verwendete Medien

Autor/Urheber: Setzner1337, Lizenz: CC0

X-ray of the hand of a 7.60 year old female, with automatic calculation of bone age by BoneXpert. The bone age is 7.38 by the Greulich and Pyle algorithm, and 8.16 by the second Tanner Whitehouse algorithm.